画像解析

画像解析 害獣検知システム

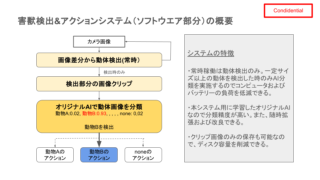

熊、猪、ハクビシン、アライグマなどによる農作物の被害が深刻になってきています。動物が接近したことをリアルタイムに検知して、動物の種類に応じた対応を行うためのカメラシステム(ソフトウエア部分)の開発について紹介します。例えば次のよう赤外線カメラ映像からリアルタイムで動物種類を分析して、動物Aならライト点灯、動物Bなら唐辛子エキスのスプレー、動物Cなら爆竹音、というようなアクションを行う装置です。ちなみに、この画像をオープンソース物体検出AIのYOLOで分析しても何も検出してくれません。また、動物の画像を切り出してYOLOで画像分類すると次のような結果になりました。この動物はアライグマと思われますが、分類結果として最も可能性の高いものは「swab」(綿棒?)と分析され、このままでは使い物になりません。そこで以下のような方針でリアルタイム分析器の開発を試みました。かなりの精度でリアルタイム分析できることがわかりました。